-

首页

-

技术与产品

- 智能硬件

- 工业互联

- ꁇ 边缘网关

- ꁇ LoRaWAN组网

- ꁇ 电力线载波通讯模组

- 电力

- ꁇ 一键顺控装置

- ꁇ 底盘车物联网控制器

- ꁇ 机械特性监测装置

- ꁇ 低压综保控制模块

- 智能硬件

- 新能源

- ꁇ 清洁机器人控制器

- ꁇ 逆变器数据采集网关

- ꁇ 红外抄表采集装置

- ꁇ 储能EMS管理机

- ꁇ 就地显示屏

- 平台软件

- ꁇ 成套设备在线监测平台

- ꁇ 智能开关柜专家诊断系统

- ꁇ 母线槽智能在线监测平台

- ꁇ 光伏清洁机器人远程运维平台

- ꁇ 光伏电站远程运维平台

- ꁇ 新型储能管理系统EMS

- AI智能体

- ꁇ 智能画图机器人

-

解决方案

- 新能源

- 光伏清洁机器人智能控制和运维解决方案

- 分布式光伏电站远程运维解决方案

- 新型储能管理系统(EMS)解决方案

- 直流电源屏在线监测解决方案

- 电力

- 成套设备在线监测物联网解决方案

- 智能开关柜整体解决方案

- 智能环网柜整体解决方案

- 真空断路器智能化解决方案

- 操作机构机械特性在线监测装置解决方案

- 母线槽智能在线监测解决方案

- 低压综保模块智能解决方案

- 工地临时配电箱在线监测物联网解决方案

- 机械装备

- AIoT智慧供热整体解决方案

- 变频器远程运维物联网解决方案

- 水泵物联网软硬件解决方案

- 科研仪器在线监测物联网解决方案

- 智能割草机远程控制物联网解决方案

- 工业缝纫机物联网解决方案

- 电梯空调远程监控物联网解决方案

- 码头卸船机远程运维物联网解决方案

- 锯床在线监测物联网解决方案

- 矿山机械远程运维物联网解决方案

-

成功案例

- 电力

- 新能源

- 机械装备

-

新闻中心

- 公司新闻

- 行业新闻

-

关于我们

- 公司简介

- 联系方式

- 加入我们

- 咨询服务

-

首页

-

技术与产品

- 智能硬件

- 工业互联

- ꁇ 边缘网关

- ꁇ LoRaWAN组网

- ꁇ 电力线载波通讯模组

- 电力

- ꁇ 一键顺控装置

- ꁇ 底盘车物联网控制器

- ꁇ 机械特性监测装置

- ꁇ 低压综保控制模块

- 智能硬件

- 新能源

- ꁇ 清洁机器人控制器

- ꁇ 逆变器数据采集网关

- ꁇ 红外抄表采集装置

- ꁇ 储能EMS管理机

- ꁇ 就地显示屏

- 平台软件

- ꁇ 成套设备在线监测平台

- ꁇ 智能开关柜专家诊断系统

- ꁇ 母线槽智能在线监测平台

- ꁇ 光伏清洁机器人远程运维平台

- ꁇ 光伏电站远程运维平台

- ꁇ 新型储能管理系统EMS

- AI智能体

- ꁇ 智能画图机器人

-

解决方案

- 新能源

- 光伏清洁机器人智能控制和运维解决方案

- 分布式光伏电站远程运维解决方案

- 新型储能管理系统(EMS)解决方案

- 直流电源屏在线监测解决方案

- 电力

- 成套设备在线监测物联网解决方案

- 智能开关柜整体解决方案

- 智能环网柜整体解决方案

- 真空断路器智能化解决方案

- 操作机构机械特性在线监测装置解决方案

- 母线槽智能在线监测解决方案

- 低压综保模块智能解决方案

- 工地临时配电箱在线监测物联网解决方案

- 机械装备

- AIoT智慧供热整体解决方案

- 变频器远程运维物联网解决方案

- 水泵物联网软硬件解决方案

- 科研仪器在线监测物联网解决方案

- 智能割草机远程控制物联网解决方案

- 工业缝纫机物联网解决方案

- 电梯空调远程监控物联网解决方案

- 码头卸船机远程运维物联网解决方案

- 锯床在线监测物联网解决方案

- 矿山机械远程运维物联网解决方案

-

成功案例

- 电力

- 新能源

- 机械装备

-

新闻中心

- 公司新闻

- 行业新闻

-

关于我们

- 公司简介

- 联系方式

- 加入我们

- 咨询服务

周志华团队新作:LLM不再需要奖励模型?我们已经"预训练"了它!首次理论证明RL对LLM有效性

过去,大语言模型(Large Language Models, LLMs)的对齐依赖一个关键组件:奖励模型(Reward Model)。奖励模型通常基于昂贵的人类偏好数据(human preference data)训练,用于指导强化学习(Reinforcement Learning, RL)以优化最终策略。

尽管这一范式有效,但其高昂的成本和低扩展性限制了实用性。

本文提出了一个颠覆性的发现:任何通过下一个 token 预测(next-token prediction)训练的语言模型,其内部已隐含一个通用奖励函数(Generalist Reward Function)。作者将其称为内生奖励(Endogenous Reward),并证明该函数在理论上等价于由离线逆强化学习(Offline Inverse Reinforcement Learning, Offline IRL)推导出的奖励函数。

更进一步,论文首次从理论上证明:利用内生奖励进行强化学习能够显著减少模仿学习中的误差累积(compounding error),使策略误差从 O(H²) 降为 O(H),提升了泛化性能与收敛稳定性。

令人惊讶的是,实验表明该方法不仅优于 LLM-as-a-Judge 框架,甚至超过了显式训练的奖励模型(explicitly trained reward models)在多个基准任务上的表现。

这一发现预示着未来的 LLM 对齐流程可以省略独立的奖励建模阶段,转向一种更加高效、可控、可扩展的新范式。

- 标题:Generalist Reward Models: Found Inside Large Language Models

- 作者:Yi-Chen Li*, Tian Xu*, Yang Yu†, Xuqin Zhang, Xiong-Hui Chen, Zhongxiang Ling, Ningjing Chao, Lei Yuan, Zhi-Hua Zhou*Equal contribution;†Corresponding author

- 机构:南京大学人工智能学院(School of Artificial Intelligence, Nanjing University)国家重点实验室(National Key Laboratory for Novel Software Technology)

- 时间:2025年6月(arXiv 预印本)arXiv 链接:https://arxiv.org/abs/2506.23235

- 关键词:

- Endogenous Reward(内生奖励)

- Inverse Reinforcement Learning, IRL(逆强化学习)

- Reinforcement Learning from Human Feedback, RLHF(人类反馈强化学习)

- Reinforcement Learning from AI Feedback, RLAIF(AI反馈强化学习)

- LLM Alignment(大模型对齐)

- Logits as Q-function(将 logits 看作 Q 函数)

- Policy Improvement Bound(策略改进误差界)

- Generalist Reward Models(通用型奖励模型)

随着大语言模型(LLM)的能力不断增强,一个核心挑战也愈发突出:如何让模型不仅能说,还能“说得对”“说得好”。为此,当前主流的对齐方法是 基于人类反馈的强化学习(Reinforcement Learning from Human Feedback, RLHF),其基本流程包括三步:首先对模型进行监督微调(SFT),然后训练一个奖励模型(Reward Model, RM)来判断回答的好坏,最后用该奖励信号指导强化学习,优化模型策略。

在这个过程中,奖励模型扮演着至关重要的角色。它是模型“判断力”的来源,也是 RLHF 成败的关键。然而,构建一个高质量的奖励模型非常昂贵。它需要大量人工标注的偏好数据,即让人类对多个候选回答进行成对比较,告诉模型哪一个更好。这不仅成本高昂、效率低下,还难以适配多样化的用户需求。

为了解决这一问题,近期出现了 RLAIF(Reinforcement Learning from AI Feedback) 等新方法。RLAIF 的思路是用强大的大模型(如 GPT-4)代替人工标注,担任“AI 裁判”,为候选回答打分。这种方法在实践中大大降低了成本,但也引发了新的疑问:这些 AI 裁判的判断是否可靠?它们是否只是复制了自身训练数据中的偏见?更重要的是,这一过程缺乏坚实的理论支撑,仍属启发式探索。

为此,本文提出了一个全新的路径:奖励信号其实并不需要从外部获取,而是早已“潜藏”在语言模型本身之中。作者发现,任何通过下一个 token 预测(next-token prediction)训练的 LLM,其输出 logits 实际上就蕴含着一个具备理论意义的奖励函数。通过一定的公式变换,可以从 logits 中提取出一种称为“内生奖励(Endogenous Reward)”的信号,用于替代传统奖励模型。这一发现不仅节省了构建 RM 的成本,更首次建立了一个有理论支撑的奖励提取机制,为 LLM 对齐带来了全新思路。

本文的核心创新在于提出“内生奖励(Endogenous Reward)”这一概念,并从理论上证明,它可以作为语言模型内部自带的高质量奖励信号,替代传统的人工训练奖励模型。

作者从逆强化学习(Inverse Reinforcement Learning, IRL)的角度出发,发现语言模型的训练目标——即“预测下一个 token 的概率”(next-token prediction)——实际上就隐式等价于 IRL 中的 reward learning 过程。

更具体地说,语言模型的输出 logits 可以看作一个 Q 函数(行为的价值函数),再通过一个数学变换(soft Bellman 逆算子)即可还原出一个奖励函数。这意味着,只要模型是用标准的 next-token 目标训练的,我们就可以直接从它的输出中提取出奖励,完全不需要额外标注或训练。

这种奖励信号被称为“内生奖励”,具有如下特点:

来源于模型本身,无需额外监督;

具有可解释的结构,与行为概率、状态价值有关;

可以被用于对比答案、指导强化学习,具备实际应用能力。

除了提出方法,作者还提供了完整的理论分析,说明内生奖励不仅可行,而且在一定条件下具备更好的性能保证。

奖励误差分析论文证明,如果语言模型的策略(即生成概率分布)与专家行为接近,那么内生奖励导出的偏好判断也会非常准确,误差有严格上界。

策略性能分析相较于模仿学习(imitation learning),内生奖励结合强化学习能更快收敛。具体来说,模仿学习误差随任务长度呈二次增长,而强化学习误差只呈线性增长,理论上更稳更强。

可收敛性分析由于内生奖励是由模型当前策略计算得出,强化学习优化一轮后即达到最优,再继续迭代也不会有进一步提升,具有自然的收敛性。

这部分工作说明:我们不必再构建外部奖励模型,语言模型自己就能“评分”自己的输出。这一结果为未来低成本、高鲁棒性的对齐方法提供了坚实基础。

作者通过一系列实证研究,验证了内生奖励的有效性与应用潜力。实验设计围绕三个核心问题展开:

内生奖励是否具有与训练型奖励模型相当的判断能力?

它能否适应不同指令,实现偏好控制?

强化学习后模型的性能是否能实质提升?

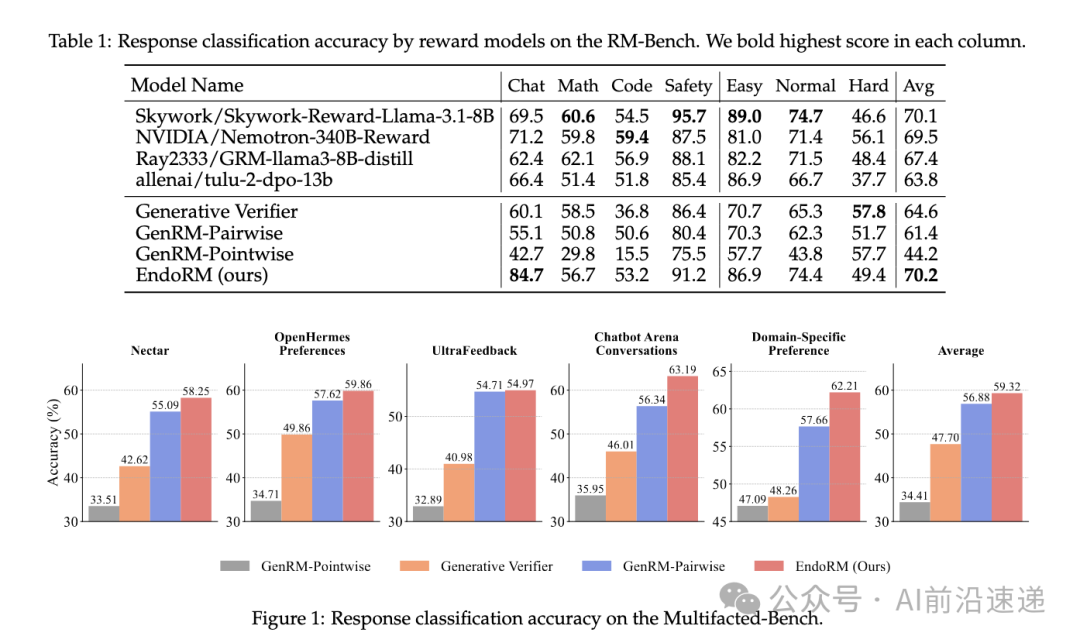

在 RM-Bench 基准数据集上,作者比较了内生奖励(EndoRM)与多个训练型和非训练型奖励模型的表现。实验采用统一的底层语言模型(Qwen2.5-7B-Instruct)以确保公平性。

结果表明,EndoRM 的整体准确率超过了所有对比模型,在聊天、代码、数学、安全性等任务上表现稳定,特别是在无需任何训练的前提下,优于多个训练代价高昂的奖励模型。

在 Multifaceted-Bench 上,EndoRM 同样展现出良好的跨任务适应能力,准确识别了多种用户偏好设置下的优劣回答。

在 Domain-Specific Preference(DSP)数据集中,作者测试了内生奖励的指令适应性。方法是:为模型提供不同领域的系统提示(如“你是学术评审员”“你是商业内容审核员”),并评估其在匹配领域的表现。

结果显示,不同指令下的 EndoRM 能够明显更好地判断该领域数据,准确率在交叉测试中呈现出清晰的对角线优势。这说明,内生奖励具备一定程度的“可提示性”,即可通过 prompt 控制其评估标准。

作者还在 MATH-lighteval 数据集上对 Qwen2.5-Math-7B 模型进行了基于内生奖励的强化学习微调。在五个数学推理子任务(AIME、AMC、Minerva、OlympiadBench、MATH-500)上进行测试。

结果显示,微调后的模型在所有子任务上均有性能提升,平均提高 5.8 个百分点。个别任务如 Minerva 提升幅度超过 10%。训练过程中未对奖励模型进行任何优化,仅使用 logits 推导出的内生奖励信号。

本文从理论与实验两个方面,提出并验证了一种无需外部监督信号的奖励建模方式。通过将语言模型的 logits 解释为 Q 函数,并结合逆强化学习的原理,作者构建出一种可直接从模型内部推导的“内生奖励”(Endogenous Reward)。

该方法具备以下特性:

- 无需人工标注:不依赖偏好数据或外部评估器;

- 免训练过程:可直接从现有语言模型中提取,无需额外模型优化;

- 具备理论基础:与最大熵 IRL 目标一致,误差界限明确;

- 适用于强化学习:在多个任务中提升模型性能,误差收敛性优于 imitation learning;

- 支持指令调控:内生奖励在不同系统提示下可调整偏好方向,具备一定个性化能力。

尽管方法简单高效,作者也指出了一些待解决的问题:

- 奖励函数完全来源于模型自身,可能会固化已有偏见;

- 内生奖励只适用于一轮强化学习优化,无法迭代提升;

- 理论分析主要基于 token-level 的语言生成,对多模态或复杂推理任务尚缺经验支持。

相比传统奖励建模方法,该机制展现出较好的解释性与工程灵活度。未来可结合稀疏人类反馈、策略聚合等方式进一步增强其稳定性和适应性,拓展其在跨任务和多模态场景下的应用边界。

注:文章来源于微信公众号《AI前沿速递》。

业务咨询

林经理:13805789089

蔡经理:15757108234

程经理:13624266840

技术咨询

曾工:15958187876